Comeza o Proxecto HAMiSoN para crear unha nova tecnoloxía contra a desinformación

A UNED coordina o proxecto HAMiSoN co obxectivo de desenvolver tecnoloxía que permita axudar a loitar contra a desinformación. Encádrase dentro do programa europeo CHIST-ERA e involucra á Universidade de Zurich para as Ciencias Aplicadas (Suiza), a Universidade de Tartu (Estonia) e a empresa Synapse Développement (Francia).

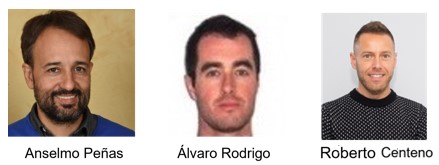

OURENSE, 9 de maio de 2023. Por parte da UNED participan tres profesores da Escola Técnica Superior de Enxeñería Informática. Anselmo Peñas Padilla, é doutor en Linguaxes e Sistemas Informáticos e especialista en diversas áreas, salientando no campo do Procesamento da Linguaxe Natural; Álvaro Rodrigo Yuste, é secretario académico do departamento de Linguaxes e Sistemas Informáticos e doutor en Intelixencia Artificial e Sistemas Informáticos; e Roberto Centeno Sánchez, profesor de Fundamentos de Informática e doutor en Informática. Anselmo Peñas fálanos do proxecto.

-Que características ten unha campaña de desinformación organizada? Son máis comúns que as orgánicas?

-A.P. En xeral, a difusión de desinformación mediante campañas organizadas é moito menos voluminosa que a difusión oportunista de desinformación. Con todo, as campañas organizadas créanse de maneira moi precisa para difundir algunhas narrativas previamente determinadas, e conségueno de maneira moi eficaz. En xeral, este tipo de desinformación correspóndese a temáticas nas que adoita haber algún axente con intereses específicos. Así, por exemplo, a difusión de desinformación ao redor da inmigración ou feminismo non adoita coordinarse, senón que distintos nodos na rede tenden a recollelas e propagalas. Por elo, as narrativas que teñen que ver con conflitos internacionais ou o cambio climático adoitan ter algún tipo de think tank detrás. De todos os xeitos, á hora de modelar o problema, non necesitamos que haxa unha correspondencia un a un entre os axentes que interveñen na difusión de desinformación no mundo real e nos modelos. En todos os casos, existe unha intención, un efecto, axentes beneficiados e axentes prexudicados. Aínda que non exista unha coordinación física no sentido de que distintas fontes puxéronse previamente de acordo, si existe unha coordinación de facto.

-Este tipo de accións son masivas ou escollen a un perfil concreto de destinatarios para facer chegar as súas mensaxes enganosas?

-A.P. Nós non temos datos respecto diso, pero evidentemente, se por algunha razón as fontes de desinformación tivesen acceso á información de perfil dos usuarios dunha rede social, dirixirán a cada perfil o tipo de mensaxe máis efectiva. Isto é o que pasou con Cambridge Analytics e Facebook no caso do Brexit. É coñecido que existe unha serie de empresas internacionais que ofrecen este tipo de servizos. Con todo, o normal é que a maioría da desinformación trate de difundirse de maneira xeral e masiva porque é moito máis barato.

-Como naceu este proxecto?

-A.P. O proxecto HAMiSoN nace grazas a unha convocatoria do programa europeo CHIST-ERA dirixido ao desenvolvemento de tecnoloxías dixitais. Nesta ocasión seleccionáronse catro proxectos para o seu financiamento co obxectivo de desenvolver tecnoloxía que permita axudar a loitar contra a desinformación. Trátase de consorcios internacionais de polo menos tres países diferentes e o obxectivo é promover a colaboración transnacional. O proxecto que coordinamos desde a UNED involucra á Universidade de Zúric para as Ciencias Aplicadas (Suíza), a Universidade de Tartu (Estonia) e a empresa Synapse Développement (Francia).

- Como funciona o modelo proposto en HAMiSoN para detectar a desinformación?

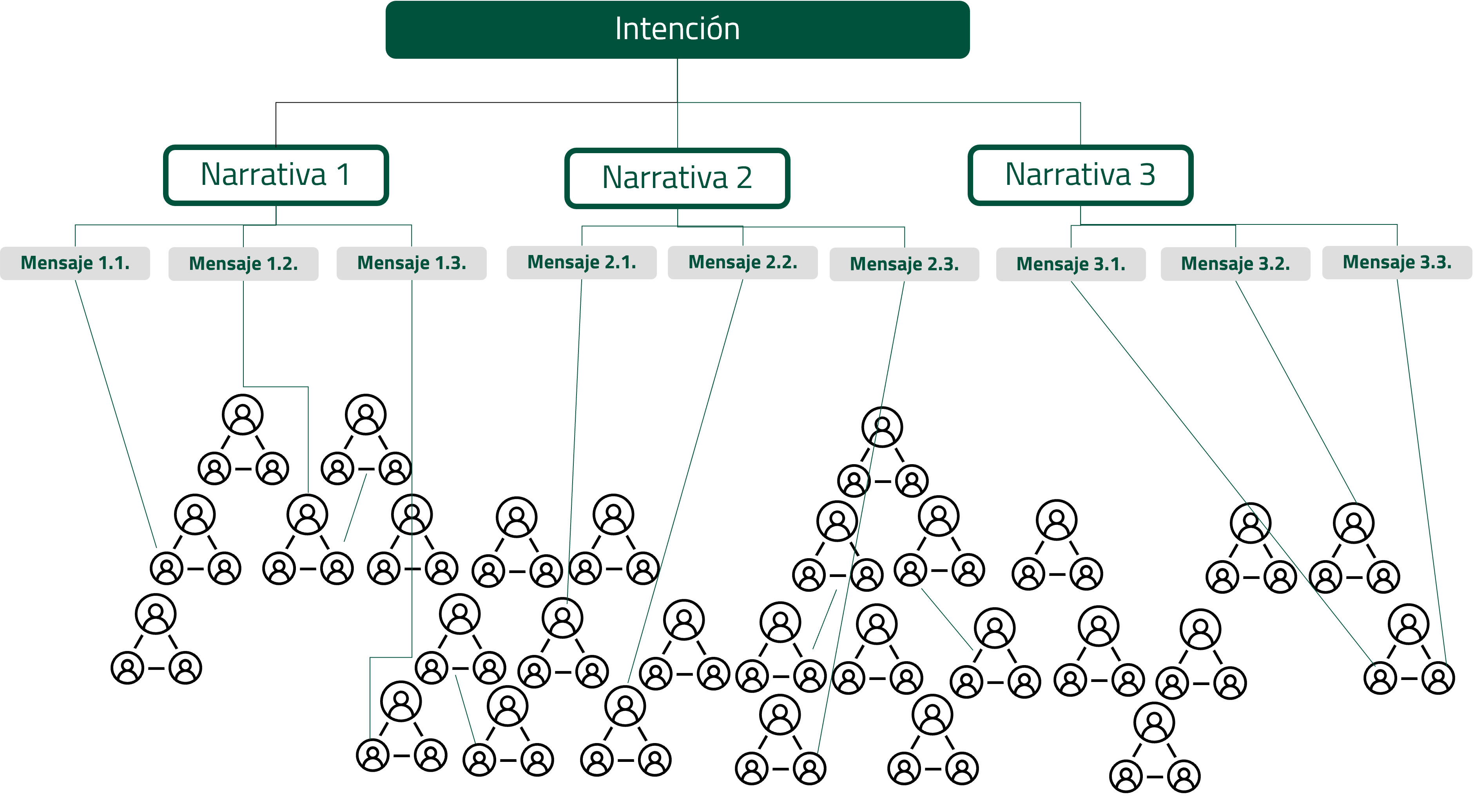

-A.P. Asumimos que calquera campaña de desinformación nace cunha intencionalidade. Esa intencionalidade maniféstase na selección e propagación de determinadas narrativas que aparecen en determinados nodos da rede de maneira máis ou menos coordinada (xa sexa unha coordinación intencionada ou oportunista). Desde un punto de vista computacional, só observamos as mensaxes que se difunden na rede, tanto o seu contido como a súa propagación. A idea é tratar de modelar o efecto, os axentes prexudicados por esa desinformación e o tipo de narrativa que se está utilizando. Desta maneira, esperamos poder relacionar mensaxes diferentes, de diferentes fontes mesmo con narrativas diferentes, pero coa mesma intención. Isto permitiríanos agregar evidencias e tratar de detectar máis mensaxes que pasaron desapercibidos inicialmente.

-Que achega HAMiSoN ás formas de detección usadas ata o de agora?

-A.P. Por unha banda, combínase tanto o texto como a forma na que a información se difunde a través das redes sociais, mentres que a maioría dos enfoques anteriores centrábanse en analizar só o texto ou só a propagación en redes sociais. A idea é combinar ambos os tipos de sinais. Doutra banda, tratamos de agrupar accións individuais dentro de campaña máis xerais, de modo que a información agregada poida darnos máis posibilidades de detectar máis mensaxes enganosas.

-O proxecto acaba de arrincar en que actividade está inmerso?

-A.P. O primeiro paso é construír os casos de uso. A nosa tecnoloxía diríxese tanto aos Fact Checkers como, por exemplo, Maldita ou Newtral, como aos analistas que fan uso dos seus servizos como, por exemplo, os observadores internacionais de eleccións políticas. Para construír os casos de uso necesitamos falar o mesmo linguaxe que estes axentes sociais. Con este fin, reunímonos con eles, recollemos datos, anotámolos e con eles buscamos maneiras de adestrar os sistemas automáticos.

-Entre os obxectivos de HAMiSoN está o de desenvolver unha ferramenta de simulación para analizar posibles campañas coordinadas de desinformación. Que tipo de aprendizaxe obtería esta ferramenta e cales son as súas aplicacións?

-A.P. A idea destes simuladores é que, unha vez axustados aos datos observados, permítannos estudar o efecto que poderían ter posibles accións mitigadoras. Por exemplo, sabemos que a maioría do contaxio prodúcese nas primeiras horas tras a emisión da desinformación, así que poderiamos tratar de simular o escenario resultante se nesas primeiras horas conseguísemos unha medida redutora do 10% (por poñer un exemplo) en determinados nodos da rede.

-Estamos aínda lonxe de previr este tipo de accións coordinadas?

-A.P. Témome que si. Por unha banda, a liña entre o que é verdade, enganoso ou mentira é moitas veces sutil. O simple feito de descontextualizar unha información xa ten un efecto intencionado no receptor. Por outra banda, a definición do problema neste momento é reactiva. É dicir, espérase a que se produza a desinformación para tratar de desmentila ou mitigala. Pero cando se consegue, o mal xa está feito. Unha das ideas do noso proxecto é que, nalgúns escenarios, podemos predicir a desinformación que se vai a propagar antes de que ocorra. Por exemplo, sabemos que en período electoral tratarase de desacreditar a maneira en que se fai o reconto electrónico de votos e, por tanto, aparecerán noticias desacreditando ás empresas que o realizan. Neste caso, pódense preparar campañas de información previa ás eleccións que axuden a inmunizarnos contra este tipo de campañas de desinformación. De todos os xeitos, a medio prazo, a mellor opción sería ir introducindo nas escolas unha especie de “educación viaria” que teña que ver coa información e a desinformación nas redes sociais. É algo que xa se fai nos países nórdicos e que creo que se acollería ben por toda a cidadanía. Todos estamos de acordo en que é un problema compartido.

-O proxecto desenvólvese dentro dun traballo conxunto coordinado pola UNED, coa participación de expertos da Universidade de Ciencias Aplicadas de Suíza, O Instituto de Ciencias Computación da Universidade de Tartu en Estonia e Synapse Développment, que perfís teñen os membros do proxecto?

-A.P. Buscamos certa complementariedade no consorcio e, á vez, un background común para poder entendernos. A UNED céntrase no uso de técnicas de Procesamento da Linguaxe Natural para a análise do contido das mensaxes, e para tratar de modelar e clasificar os efectos e narrativas difundidas polas mensaxes. Tamén vai realizar simuladores baseados en técnicas de multi-axentes. A Universidade de Tartu céntrase na análise das redes sociais. A Universidade de Ciencias Aplicadas de Zúric aborda aspectos multimodales da información como son o audio e o vídeo. Finalmente, Synapse ten o rol de que a tecnoloxía desenvolvida poida transferirse á sociedade.

UNED Ourense

UNED Ourense

Comunicación