Julio Gonzalo, catedrático da UNED, sinala que en IA se fala pouco do sesgo producido por mecanismos de avaliación inadecuada

O catedrático da ETSI de Informática da UNED impartiu un relatorio no seminario que a Universidade desenvolve en Ourense sobre a Intelixencia Artificial

OURENSE, 4 de decembro de 2020.-O "sesgo" é un tema de tendencia no contexto da intelixencia artificial e a ciencia de datos, e por unha boa razón: cada vez máis procesos de toma de decisións nas nosas vidas (como obter un préstamo ou ser entrevistados por un traballo) están mediados polo sistemas de Intelixencia Artificial; e tanto a comunidade investigadora como a sociedade en xeral son cada vez máis conscientes de que a aprendizaxe automática é tan propensa ao sesgo como a cognición humana. A maioría das investigacións sobre o sesgo do sistema céntranse actualmente nos sesgos introducidos polos algoritmos e / ou os datos utilizados polos algoritmos para aprender. Pero os sistemas de IA adoitan ser o resultado dun proceso de "selección natural" no que a avaliación iterativa, tanto dentro como fora do laboratorio, desempeña un papel crave. En consecuencia, os sesgos nas nosas metodoloxías de avaliación poden ter un impacto substancial nos sistemas. Disto falou en Ourense o catedrático Julio Antonio Gonzalo Arroyo, da Escola Técnica Superior de Enxeñería Informática da UNED, no departamento de Procesamento da Linguaxe Natural e Recuperación de Información.

Supoñamos, como sinala o relator, que estamos no ano 2040 e que, en España, o Goberno decide que o coñecemento dos economistas non é fiable, e cambia o posto de ministro de Economía por un sistema de Intelixencia Artificial. Ao sistema pídeselle que mellore a economía do país, pero ese é un obxectivo vago, que a máquina non entende, así que se traslada en algo medible: optimizar o Produto Interior Bruto. Ao cabo de tres anos o Goberno observa que, en efecto, o PIB do país creceu de forma nunca vista, pero ao mesmo tempo detecta moitos efectos colaterais indesexados: o horario dos traballadores é de 12 horas diarias (así producen máis), creceron os verquidos de petróleo ao mar (recoller os verquidos é actividade económica, que incrementa o PIB), o país enteiro quedou deforestado, prohibíronse os servizos gratuítos (como os buscadores da internet) porque non contribúen ao PIB, etc.

O problema foi que o sistema de Intelixencia Artificial cumpriu os nosos desexos literalmente, pero non soubemos expresalos con suficiente precisión. “A moralexa é que cando un sistema de Intelixencia Artificial concédenos un desexo, máis vale tomalo con calma e pensalo dúas veces antes de enuncialo” explica o catedrático da UNED, Julio Gonzalo.

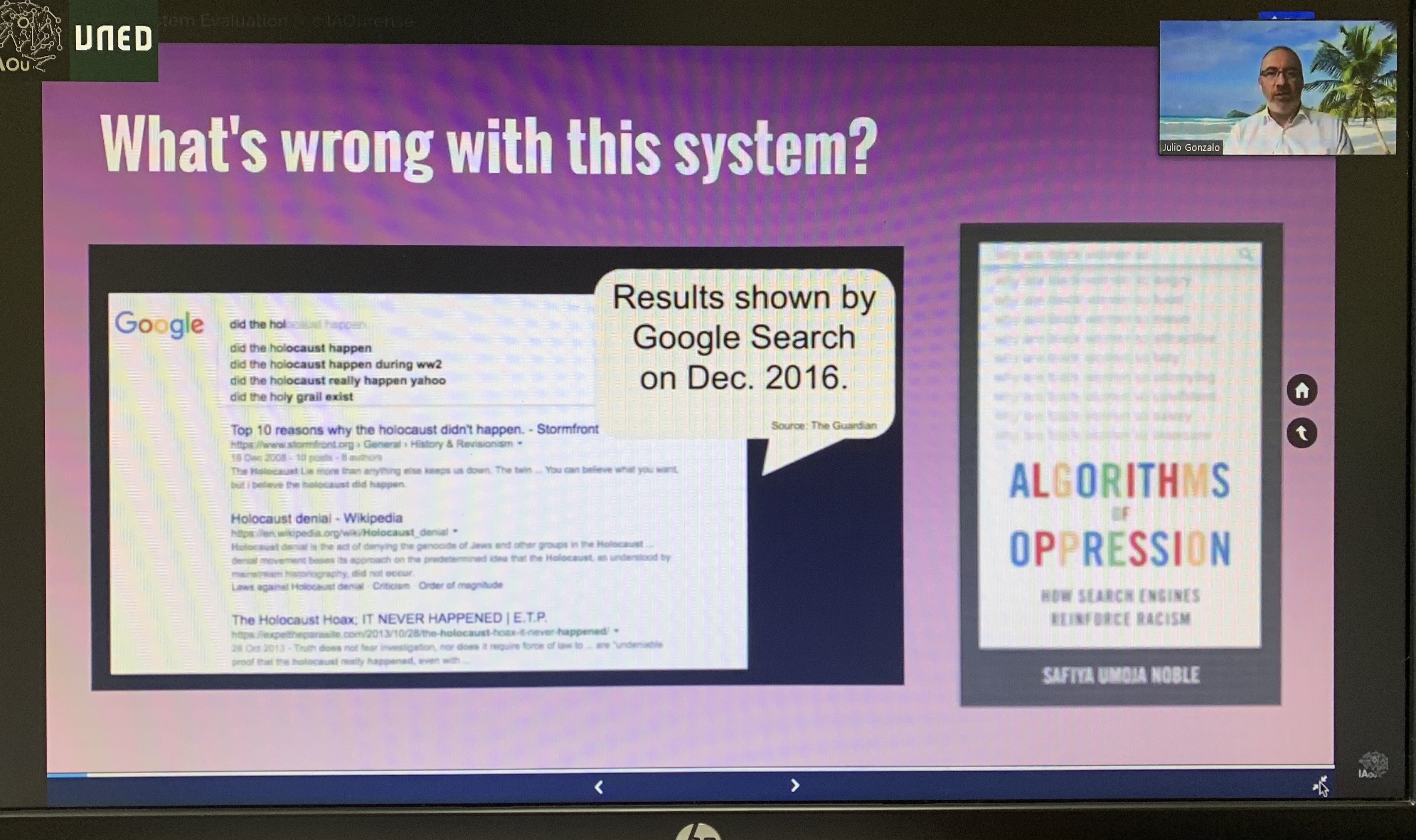

Gonzalo Arroyo pon como exemplo Youtube: “se buscas información sobre a cura do cancro en Youtube verás que en primeiro lugar, aparecen informacións que din que o mollo de remolacha cúrao en 48 horas; de feito, o 74% de resultados en español en Youtube para esa consulta son pura desinformación”. Con todo, o algoritmo só fai o que se lle pediu, o criterio matemático polo que se avalía a súa aprendizaxe: maximizar o tempo medio de visualización dos usuarios. Outro exemplo típico, buscar en Google e preguntar se ocorreu o Holocausto nazi. Hai uns anos, os primeiros resultados eran sitios negacionistas. Unha vez máis, o algoritmo fai o que lle pediron, neste caso, maximizar a satisfacción do usuario. E poida que os que fan esta pregunta é máis probable que estean interesados nunha resposta negacionista. O problema non está no algoritmo, senón na métrica de calidade. “Por tanto, se un algoritmo concedéseche tres desexos, pénsacho dúas veces!”, chancea o relator, quen puxo de relevo na súa intervención que existe un rumbo da avaliación e non se fala diso o suficiente.

Esa función obxectivo que lle damos ao sistema de Intelixencia Artificial ten moito que ver coa forma en que se avalían os sistemas intelixentes. Este experto disertou en Ourense sobre o sesgo nos sistemas de avaliación. “A IA actual consiste, de forma predominante, en algoritmos que aprenden a partir de exemplos, tratando de maximizar unha función obxectivo que estima o nivel de éxito desa aprendizaxe. En IA fálase moito de como o sesgo dos datos produce un sesgo no algoritmo (por exemplo, se se aprende a linguaxe a partir de textos nesgados cara ao racismo ou misóxino, o sistema expresarase de forma misóxina e racista). Con todo, fálase moito menos do sesgo que se produce por uns mecanismos de avaliación inadecuada (por exemplo, poñer o PIB como métrica de avaliación para o algoritmo, cando o que realmente se quere é mellorar a economía)”, explica Julio Gonzalo. Na súa charla revisou os distintos aspectos da avaliación de sistemas que poden ser fontes de sesgo: as métricas de avaliación, os datos de proba, o deseño experimental e as ferramentas de análises de resultados. E discutiu como as malas prácticas na avaliación de sistemas poden dar lugar a sesgos indesexados no seu comportamento, e cales son os desafíos para eliminalos.

Este seminario organizado pola UNED emítese desde o Centro de Intelixencia Artificial do Concello de Ourense, que convidou á Universidade a incluir esta actividade no seu ciclo Os Venres con IA.

Podes seguir o relatorio pulsando aquí.

UNED Ourense

UNED Ourense

Comunicación